K3s para demos, muchas ventajas sobre Kubernetes por despliegue y tamaño.

Etiqueta: contenedores

Kubernetes: Crear un entorno mínimo para demos

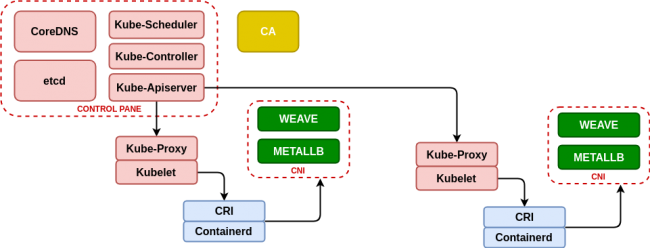

Crear un entorno mínimo para demos de Kubernetes

Elegir entre Docker o Podman para entornos de pruebas y desarrollo

¿Cuando elegimos Docker o Podman? Muchas veces nos encontramos que tenemos muy pocos recursos y necesitamos un entorno para realizar una completa demostración de producto a un cliente. En esos casos vamos a necesitar simular un entorno de la manera más sencilla y con menos recursos posibles y para ello usaremos contenedores, pero ¿cual es la mejor solución para esos pequeños entornos? Docker Docker es el entorno de contedores estandar en el mercado, es el más extendido y conforma un conjunto de herramientas extraordinariamente potentes como son un cliente desde linea de comandos, un API server, un gestor del ciclo de vida de los contenedores (containerd), un lanzador de contenedores (runc). Instalar docker es realmente fácil, ya que docker suministra un script que realiza el proceso de preparar y configurar los requisitos y los repositorios necesario y por último instala y configura docker dejando el servicio listo para usar. Podman Podman es un entorno de contenedores que no utiliza un servicio y por lo tanto no dispone de un API server, las peticiones se hacen únicamente desde la linea de comandos, lo que tiene ventajas y desventajas que explicaremos al final. Instalar podman es fácil en un entorno Centos (yum install -y podman para Centos 7 y yum install -y container-tools para Centos 8) pero necesita cierto trabajo en un entorno Debian: Despliegue con Ansible En nuestro caso hemos utilizado los roles Ansible desarrollados en https://github.com/aescanero/disasterproject, para desplegar dos máquinas virtuales, una con podman y la otra con docker. En el caso de usar una distribución basada en Debian instalamos Ansible: Procedemos a descargar el entorno y configurar Ansible: Editamos el archivo inventory.yml y le ponemos el siguiente formato: Existen algunas variables globales que cuelgan de “vars:”, que son: network_name: Nombre descriptivo de la red de libvirt que crearemos y que además será el nombre del interface que se configurará en el anfitrión KVM y que servirá de puerta de enlace de las máquinas virtuales network: los tres primeros campos de la dirección IPv4 para confirmar una red con máscara 255.255.255.0, las máquinas virtuales deberán tener una IP de dicho rango (menos 0,1 y 255) El formato de cada equipo se define por los siguientes atributos: nombre: Nombre descriptivo de la máquina virtual a desplegar, será además el hostname del equipo memory: Memoria de la máquina virtual en MB vcpus: Número de CPUs virtuales en la máquina virtual vm_ip: IP […]